图片来源:视觉中国

开源大模型在AI竞赛中再扳回一城。

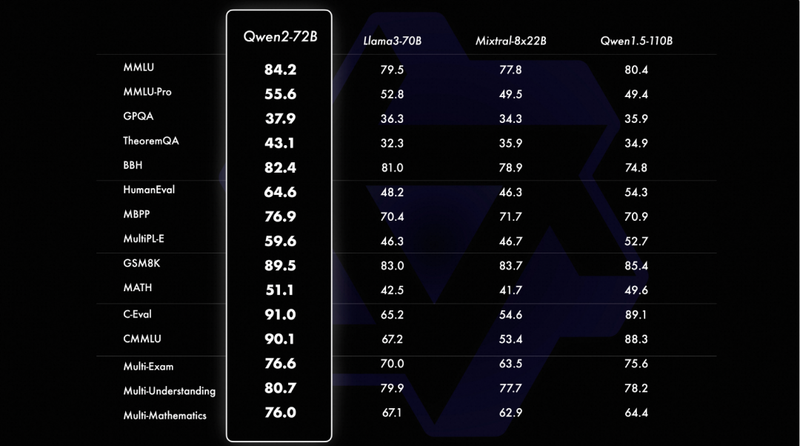

6月7日,阿里云发布开源模型Qwen2-72B。根据官方宣称,Qwen2不仅超过此前Meta推出的开源模型Llama3-70B,也超过了百度文心4.0、字节豆包pro、腾讯混元pro等众多中国厂商的闭源大模型。

据阿里云介绍,本次开源的Qwen2-72B大模型在自然语言理解、知识、代码、数学及多语言等多项能力上均显著超越当前领先的开源模型,包括阿里云在4月底开源的Qwen1.5最大的模型Qwen1.5-110B。

图片来源:阿里云

阿里云通义千问团队披露称,Qwen2实现了整体性能的代际飞跃。该系列包含5个尺寸的预训练和指令微调模型,包括Qwen2-0.5B、Qwen2-1.5B、Qwen2-7B、Qwen2-57B-A14B和Qwen2-72B。所有尺寸模型都使用了GQA(分组查询注意力)机制,以便让用户体验到其带来的推理加速和显存占用降低的优势。此外,模型的多语言能力和上下文长度支持均得到了提升。

目前所有用户都可以在阿里旗下的AI模型社区魔搭社区和开源平台Hugging Face上免费下载开源模型Qwen2-72B。

在Qwen2发布后,Hugging Face联合创始人兼首席执行官Clement Delangue也很快在社交平台X上发帖表示,其开源大模型榜单迎来了新的第一。

许多国外的开发者也纷纷表示欢迎,“这个开源大模型就如同今天SpaceX成功发射的星舰一样重要!”一位网友评论称。

通义千问Qwen系列开源模型正在成为Meta的Llama系列大模型之外的另一选项,在国外开发者社区中也获得了较高的讨论度。据官方信息,通义千问Qwen系列模型在近一个月内的总下载量翻了一倍,已突破1600万次,全球开源社区出现了超过1500款基于Qwen二次开发的模型。

如果Meta是国外开源阵营的执旗者,那么国内则站着阿里云、腾讯等国内大厂以及百川智能、智谱AI等初创企业。

他们认为开源能够降低使用门槛,带动大模型生态的繁荣,大多采取的是开源和闭源模型并行的策略。阿里云此前除了开源1100亿参数的Qwen1.5-110B模型,还同时发布了闭源大模型通义千问2.5。

而大模型闭源的拥趸则认为,为了保持领先,选择闭源的企业会投入大量的成本在模型的质量和安全上,并祭出了一个强大的例子——采取完全闭源的OpenAI。

百度CEO李彦宏曾多次表示,大模型开源意义不大,闭源模型在能力上会持续地领先,而不是一时地领先,“开源模型会越来越落后”。

在这番发言后不久,Meta就推出了当时能力最强的开源模型Llama 3,具备8B和70B两个版本。

阿里云CTO周靖人在回应开闭源之争时曾指出,“Llama 3把竞争的水位拉得很高。坦诚地说,不是所有闭源公司的模型都能比得上开源模型,至少闭源模型要能超过开源模型水准,才有机会参与这样的讨论。”

在发布本次开源模型时,周靖人再次强调,坚持开源开放是阿里云的重要策略,阿里云希望让算力更普惠、让AI更普及。

除了这些上价值的口号之外,把先进的大模型开源对阿里云来说也有很多现实意义。

一方面,作为头部云厂商,阿里云具备充足的算力、通信网络等AI基础设施,能够支持开源大模型的研发和训练。另一方面,在“AI驱动、公共云优先”的策略下,阿里云希望通过开源模型吸引更多的企业和开发者,使用其供应的基础设施,带动其云计算业务的增长。

阿里巴巴集团董事长蔡崇信5月31日在上海举办的摩根大通中国峰会中谈及,“在业界,阿里巴巴可能是极少数同时拥有强大人工智能业务和领先云计算业务的公司之一。”他指出,人工智能与云计算的紧密结合至关重要。当用户在社区内使用开源人工智能工具时,他们自然需要计算资源,这也是阿里云计算收入得以增长的重要推动力。

因此,阿里云有足够的动力积极推动其开源模型为开发者所接受,以便加快其云计算业务的销售。

据阿里2024财年Q4及全年业绩,阿里云季度收入增长3%至255.95亿元,核心公共云产品收入实现两位数增长,AI相关云产品实现三位数增长。在业绩会上,管理层预计云业务下半年将恢复至两位数增长,主要受AI新产品的驱动。