图片来源:图虫创意

童书作家两色风景在过年时经常接到一个电话,电话里的女声一开始会假装自己没听清,连叫几声“喂?喂?”然后用一种难以置信的、欣慰的语调:哎!您的电话可算是接通啦,是这样的,您有一笔钱即将到账,数额是……

如果以前的AI诈骗电话一听就是僵硬的、套路固定的机器人,那么现在AI合成的电话,则是有视频、有声音、语调有情感,能根据实时对话内容来调整多轮对话的反馈。

今年2月,香港一家跨国公司员工,被骗子邀请进了用Deepfake做的“高管视频会议”中,下令让他转了2亿港币到不知名中账户,5天之后才发现被骗了——之前会议中的高管的形象,是根据YouTube上这些高管公开的视频资料,用Deepfake伪造的。

AI技术的发展,既便利了我们,又为一些犯罪分子提供了新的手段。

ChatGPT+Sora的王炸组合可能被利用

Deepfake深度伪造技术并不新鲜,它是指“生成式对抗网络”(GAN)的机器学习模型将图片或视频合并叠加到源图片或视频上,借助神经网络技术进行大样本学习,将个人的声音、面部表情及身体动作拼接合成虚假内容的人工智能技术。

但近两年飞速发展的大语言模型,规模庞大,包含数十亿的参数,使AI从量变到质变。大模型的发展对Deepfake深伪技术有推动吗?

会的。算法与模型的改进,都让Deepfake更加仿真。

在四川工作的信息安全工程师林泉(化名)表示:“算法方面,比如说以前要训练一百万(虚指)张图片才能达到某种效果,现在通过算法的精进,一千张图片就能达到同样的效果。另一方面是模型本身的提升,比如以前用一百万张图来训练模型,现在训练更精细,用一千万张图片来训练模型,效果肯定会更好。”

而今年2月由OpenAI发布的文生视频模型Sora,能生成长达1分钟的多镜头长视频,其高清画质、多角度运镜对于视频生成领域是划时代的。

人工智能自媒体“超级头脑”博主张泽伟目前在用AI为一些客户定制虚拟数字人,或者定制亲人形象的视频电话。他表示,像Sora、Runway这样的视频生成模型,能使数字人形象不仅像以往一样出现在单一背景中,而是能出现在多种不同的背景中,甚至背景可以移动起来。这样加强了AI视频电话的仿真度。

但这样的技术若被不法分子用于诈骗,危害也将更大。林泉表示,AI视频电话中让人物形象在不同背景中运动的技术早已有之,但以前的模型生成的视频长度比较短,Sora的厉害之处在于视频生成长度达到一分钟,增加了视频的连贯性,“它可以模仿一个人走在路上拿着手机打视频电话。”

林泉提出,ChatGPT(文字聊天机器人)+Sora(文生视频模型)的组合,有可能被利用生成危害更大的诈骗手段——诈骗者可能先用ChatGPT跟客户聊天,再根据聊天内容用Sora实时生成视频画面。

在ChatGPT推出两个月后,2023年2月,网络安全公司Check Point就发现网络犯罪分子已绕过 ChatGPT 的防护措施来生成恶意软件。 Check Point 研究人员在对暗网论坛进行了监控,发现黑客在讨论如何使用聊天机器人“改进”恶意软件代码,包括一些几乎没有编程经验的“脚本小子”正在使用ChatGPT编写可用于间谍、勒索软件、恶意垃圾邮件和其他用于不法活动的软件和电子邮件。

AI也只是一种工具

曾经,讲方言是识破诈骗电话的一种手段。一起去年发生的电话诈骗案例中,当事人亲子之间约定讲方言来确认对方确实是亲人。

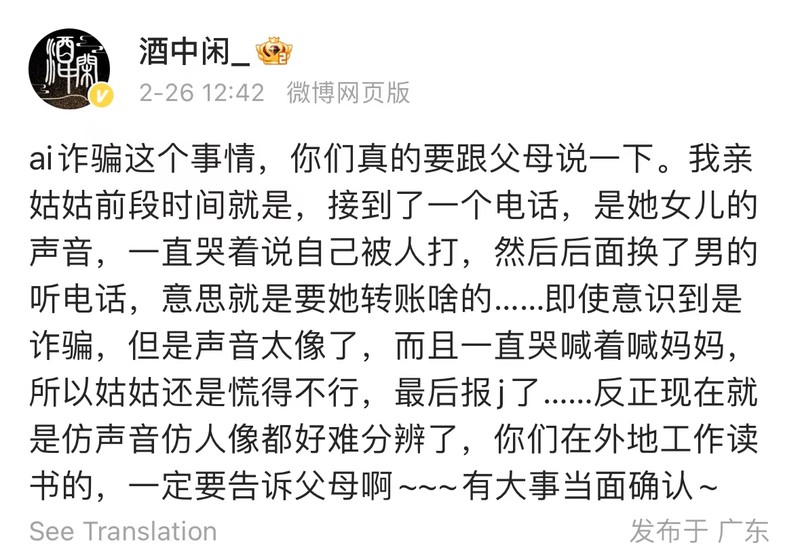

但是,用AI合成的方言语音诈骗电话也越发频繁。在微博上,今年2月底,多名广东地区的用户表示接到了模拟亲人声音的电话,要求转账。一名网友表示,电话那头是用粤语方言讲的,“即使意识到是诈骗,但是声音太像了”。

网友遇到的方言诈骗电话。图片来源:微博

“方言诈骗其实很简单。”林泉就解释说。

如果要诈骗一个人,最容易拿到手的就是电话号码,电话号码有地区显示。打过去后,诈骗分子即使发现对方讲的地区语言不符合预期,直接挂掉电话就行,几乎没有成本。

林泉介绍到,接下来就是普通的电话诈骗方式了:用户若点击某些非法链接、安装某些非法程序,内含病毒,病毒在手机内植入应用,窃取通讯录信息,获得麦克风授权。当这个用户每次讲话,病毒应用会通过麦克风收集语音数据,“然后在你手机里,不知道哪里的目录里,生成一个音频文件。”

病毒软件再用这些窃取的音频数据,来训练语音机器人或AI虚拟人。因为病毒应用窃取了受害者的通讯录,里面很可能有叫‘妈妈’的联系人,诈骗者就很容易打电话给其父母,再用AI伪装成孩子的声音,编一个理由,要求转账。

更危险的诈骗形式是黄赌毒,黄赌毒的骗局一直设置得精致严密,AI只是让整个系统运转更高效、以假乱真。

黄赌毒诈骗的危险在于,个人信息上传、赌局输赢数据、赌局流程推动、直播画面、聊天互动全部都在诈骗网站或软件上进行,形成闭环,受害者的全流程金融信息被诈骗分子掌控,受害者在赌博平台上看到的一切数据与画面也是诈骗分子人为操控的。

相比之下,打电话冒充亲人、要求转账的诈骗形式太低级了——这需要挨个打电话来尝试。林泉表示,更高级的套路是,“(诈骗分子)在自己的平台里面,让你往里面充值来赌博,让你把身份证、银行卡都上传了,你的一切信息都进入别人的平台了。”

图片来源:视觉中国

而在这些黄赌毒诈骗中,林泉表示,可能利用AI技术的环节有两个:一是美女荷官的影像合成;二是用AI实现自动发牌。

还能用AI实现自动发牌,“这个发牌程序要定制的,比如说,让你赢3局、输1盘,再赢5盘、又连输10盘,你只要上钩,最后总共10盘里,你只要输上一盘,诈骗者都能赚。你参与得越深,诈骗者等到赚得差不多了,你也没钱了,美女荷官就不理你了,聊天机器就把你拉黑。”设计好程序,等到客户投入金额大于某个数值,程序就自动把客户拉黑(使客户无法追回欠款)。

林泉作为信息安全工程师对这些黄赌毒骗局进行拖库(指从数据库中导出数据)时,也感到惊奇:“一个黄赌毒诈骗的APP,刚发布一两个月,里面就有上千万的资金流动,上万人活跃。”

林泉也提出警告,诈骗行为的本质是由金钱驱动的,只要有利益可图,就永远有一批技术高超的诈骗分子想要利用技术去牟利,跟是不是AI没有太大关系,AI并没有让诈骗率提高。“AI和诈骗有相关性,但没有因果性。”

至于防范措施,林泉表示,不用害怕手机病毒,病毒大部分时候是人为主动下载的(点击了非法链接,下载了不明软件),病毒的权限也是人为主动授予的。不要安装来源不明的app,不要随便给来源不明的APP授予“通讯录”“定位”“文件读取和存储”权限,推荐去“应用商场”下载可信来源的软件。

跟电话、互联网一样,AI也只是一个中性的工具,它既可以被有效利用于我们日常的生产生活,也能被犯罪分子用于诈骗。但并不能因此就饮鸩止渴,还是要想办法在发展中解决AI发展带来的问题。