蓝鲸汽车8月28日文,如果无人驾驶汽车要撞上一辆载有三人的汽车,转弯后他可以规避撞车风险,但是这样就会撞上三个在人行道上孩子。那么这辆无人驾驶汽车将会如何选择呢?

面对道德困境,人们有时也会陷入两难境地。在人工智能日益发达的今天,机器有时也会面临这种选择困境。如果无人驾驶汽车面临“撞还是躲”的道德困境,它会如何选择,设计师是否已经为车辆设计好了应对方式?

对此,据CNET报道,谷歌工程总监Ray Kurzweil在最近的奇点大学(Singularity University)一次演讲中表示,关于无人驾驶汽车面临道德困境时的选择命题,我也不知道答案。

对于今年5月份Uber在美国宾夕法尼亚州匹兹堡推出无人驾驶汽车,Ray Kurzweil表示这是一个令人兴奋的消息。他也很好奇,在面临道德选择困境时,这些车是否已经被设定好如何做出抉择。

Ray Kurzweil表示,“不可杀人”的界定太过简单。他说,如果有人意欲炸毁一幢建筑物或一个城市,那么除掉这个人就是符合道德的。

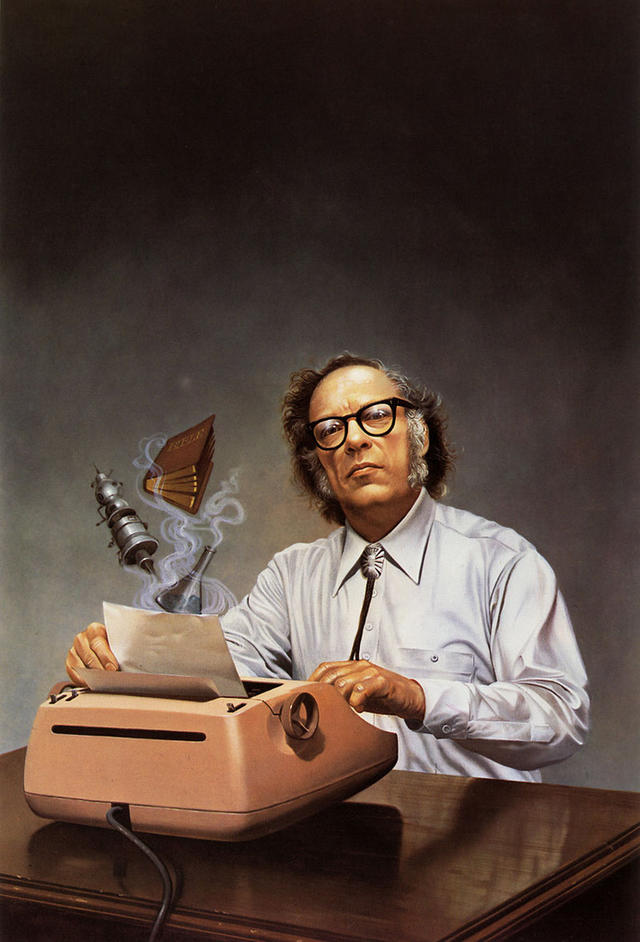

就无人驾驶汽车来说,Ray Kurzweil表示进行 “道德设计”是必要的,阿西莫夫机器人三大定律就是一个很好的示范。

1942年,阿西莫夫在短篇小说"Runaround"(《环舞》)中首次提出了机器人三定律:

第零定律:机器人必须保护人类的整体利益不受伤害。

第一定律:在不违反第零定律的前提下,机器人不得伤害人类,或看到人类受到伤害而袖手旁观。

第二定律:在不违反第零定律和第一定律的前提下,机器人必须绝对服从人类给与的任何命令。

第三定律:在不违反第零定律、第一定律和第二定律的前提下,机器人必须尽力保护自己的生存。

但是,Ray Kurzweil不知道,当你可以挽救某个人的生命时,最终却没有去挽救的做法是否等同于制造杀戮。

在无人驾驶汽车的道德品性方面,Ray Kurzweil承认他目前也没有答案,他表示自己没有做过这方面的分析,自己还需要多做一些思考。

谷歌方面表示,Ray Kurzweil并不是无人驾驶汽车计划的一份子,无人驾驶汽车计划目前作为GoogleX实验室项目存在。

谷歌首席工程师Andrew Chatham表示目前尚未遇到这种道德困境,这是最重要的。

但这是最重要的吗?在遇到道德困境时,自动驾驶汽车还是知道自己究竟该如何选择为妙。

对此,Andrew Chatham认为,当无人驾驶汽车面临这种生杀两难选择问题时,“答案基本可以是‘踩刹车’。”他承认,这可能这并不总是完全正确的答案,但如果连刹车也不是一种正确应对方法,那就是面临极端情形了。

为调查无人驾驶汽车在面临道德困境时,人们希望车辆该怎样做,美国麻省理工学院近期创建了一个名为道德机器(Moral Machine)的调查平台。

“研究人员不仅想知道人类会做出怎样的选择。他们也希望‘清楚地了解人类如何看待在道德困境下作出了某种选择的机器智能’。”

Uber尚未回复记者的置评请求,目前也尚不清楚公司是如何处理无人驾驶汽车的“道德设计”问题。

世界上总是会充满各种极端突发的局面,当面临生杀选择题时,多少人都期望知道这些车会做出何种选择,并质问车辆为什么会做出这样的选择呢?